La "Singolarità" è quel punto omega, previsto entro il 2030 da scienziati come Vernor Vinge e Raymond Kurzweil, che prevede la realizzazione di una Intelligenza Artificiale "forte" (o I.A. avanzata) ovvero di un computer pensante. Invero essa potrebbe realizzarsi anche attraverso un interfacciamento neurale di un cervello umano a una macchina I.A. in modo da realizzare un essere dalla potenza cognitiva superiore. Altresì la singolarità potrebbe emergere come autocoscienza dalla stessa rete Internet a causa dei miliardi di interazioni tra computer che simulerebbero in tutto è per tutto una rete neuronale. Quest'ultima ipotesi io la scarterei poiché essa non tiene conto della "organizzazione funzionale" della rete neurale (ammesso che di rete neurale possa parlarsi). Se pensiamo ad esempio alla rete neurale del cervello dell'orca ci accorgiamo che essa è più estesa della nostra (il cervello è più grande) ma questi animali, pur mostrando comportamenti intelligenti, non hanno sviluppato la fisica...

La "Singolarità" è quel punto omega, previsto entro il 2030 da scienziati come Vernor Vinge e Raymond Kurzweil, che prevede la realizzazione di una Intelligenza Artificiale "forte" (o I.A. avanzata) ovvero di un computer pensante. Invero essa potrebbe realizzarsi anche attraverso un interfacciamento neurale di un cervello umano a una macchina I.A. in modo da realizzare un essere dalla potenza cognitiva superiore. Altresì la singolarità potrebbe emergere come autocoscienza dalla stessa rete Internet a causa dei miliardi di interazioni tra computer che simulerebbero in tutto è per tutto una rete neuronale. Quest'ultima ipotesi io la scarterei poiché essa non tiene conto della "organizzazione funzionale" della rete neurale (ammesso che di rete neurale possa parlarsi). Se pensiamo ad esempio alla rete neurale del cervello dell'orca ci accorgiamo che essa è più estesa della nostra (il cervello è più grande) ma questi animali, pur mostrando comportamenti intelligenti, non hanno sviluppato la fisica...

Ora: quando la mente artificiale verrà creata essa sarà l'ultima invenzione che l'essere umano avrà potuto fare. Da quel momento in poi essa, dato che sarà superintelligente, progetterà nuove I.A. ancora più evolute e le stesse realizzeranno una sorta di "boom" in ogni campo della scienza rivoluzionando la matematica, la fisica, la biologia e la tecnologia in generale: gli esseri umani ne saranno surclassati e non potranno più arrivare a comprendere i progetti delle intelligenze avanzate. Nessuno potrà prevedere cosa accadrà dopo questo evento poiché esso sfuggirà alla nostra comprensione.

Uno dei pilastri su cui si fonda l'assunto della singolarità è la "Legge di Moore": una osservazione empirica compiuta nel 1965 da Gordon Moore, cofondatore di Intel (la casa che costruisce i processori per i nostri computer). Questa legge afferma che il numero di componenti elettronici (transistor) che formano un microprocessore sarebbe raddoppiato ogni anno che passa. Questa legge è un esempio lampante di futurologia scientifica (ovvero di una previsione del futuro fatta da uno scienziato) tant'è che è valida ancora oggi: ogni 18 mesi circa la potenza di elaborazione di questi piccoli "cervelli digitali" raddoppia! Il fenomeno è evidente nella evoluzione del Personal Computer (Pc), il cui processore è evoluto dai 29.000 transistor del primo Pc Ibm nel 1980 (Intel 8086) agli 810.000.000 del più recente processore (Intel i7) con un aumento della complessità circuitale pari a 28.000 volte (!). Kurzweil dunque afferma che nel 2021 avremo computer capaci di elaborare la stessa quantità di informazioni di un cervello umano ed è molto probabile che abbia ragione. Sono inoltre allo studio complete mappature neurali del cervello per poterne realizzare una emulazione. Tuttavia questa teoria non tiene conto di un fatto; un computer è costituito da due componenti:

HARDWARE + SOFTWARE

E senza il secondo il primo non funziona. Qualsiasi microprocessore o rete neurale artificiale, per quanto evoluti, senza software sono solo ammassi inutili di circuiti! Ora: mentre la tendenza evolutiva dell'hardware è un fatto accertato è altrettanto accertato che l'evoluzione dei software avviene in modo decisamente più lento, anzi, a voler essere sinceri: parossisticamente più lento. Ciò è dovuto al fatto che a sviluppare il software sono sempre esseri umani ovvero esseri che soffrono di limitazioni cognitive.

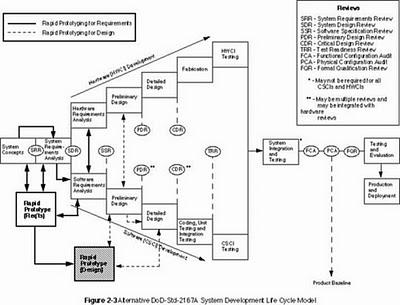

Ben sapendo questo un gigante come Microsoft, per la realizzazione del suo sistema operativo Windows e dei software applicativi ha diviso il sistema di sviluppo in "moduli". Ogni modulo è affidato ad un team di sviluppo umano (15-30 programmatori) che si occupa di generare il codice per quella parte. Poi tutti i moduli vengono assemblati a formare il Kernel e vengono avviati lunghissimi periodi di debugging e di beta testing che prevedono anche il rilascio in commercio di pre-release del prodotto. Infatti uno dei problemi legati allo sviluppo di software da parte di esseri umani è la continua errorazione che viene prodotta nei vari moduli o nell'assemblaggio degli stessi: due moduli possono funzionar bene da soli ma una volta accoppiati generano errori. Non solo, spesso accade che un sistema software (ad esempio un sistema operativo) funzioni benissimo su un determinato hardware ma quando viene posto a contatto con driver (software pilota) diversificati genera errori imprevisti; per questo Microsoft prevede la Driver Certification WHQL. Quello che vedete in alto in figura è uno schema di sviluppo software della ministero della difesa americano in modo che lo stesso risulti il più possibile privo di bug. Come vedete le fasi prevedono iter lunghi e complessi... Concludo dicendo che se vediamo oggi il computer più potente: l'IBM RoadRunner esso monta 20.000 processori, ha 100 Terabyte di Ram e genera una potenza di calcolo di 1.105 Teraflops (!) eppure, nonostante tutto, gira su un sistema operativo Linux, ovvero lo stesso che usiamo sui nostri notebook...

Ben sapendo questo un gigante come Microsoft, per la realizzazione del suo sistema operativo Windows e dei software applicativi ha diviso il sistema di sviluppo in "moduli". Ogni modulo è affidato ad un team di sviluppo umano (15-30 programmatori) che si occupa di generare il codice per quella parte. Poi tutti i moduli vengono assemblati a formare il Kernel e vengono avviati lunghissimi periodi di debugging e di beta testing che prevedono anche il rilascio in commercio di pre-release del prodotto. Infatti uno dei problemi legati allo sviluppo di software da parte di esseri umani è la continua errorazione che viene prodotta nei vari moduli o nell'assemblaggio degli stessi: due moduli possono funzionar bene da soli ma una volta accoppiati generano errori. Non solo, spesso accade che un sistema software (ad esempio un sistema operativo) funzioni benissimo su un determinato hardware ma quando viene posto a contatto con driver (software pilota) diversificati genera errori imprevisti; per questo Microsoft prevede la Driver Certification WHQL. Quello che vedete in alto in figura è uno schema di sviluppo software della ministero della difesa americano in modo che lo stesso risulti il più possibile privo di bug. Come vedete le fasi prevedono iter lunghi e complessi... Concludo dicendo che se vediamo oggi il computer più potente: l'IBM RoadRunner esso monta 20.000 processori, ha 100 Terabyte di Ram e genera una potenza di calcolo di 1.105 Teraflops (!) eppure, nonostante tutto, gira su un sistema operativo Linux, ovvero lo stesso che usiamo sui nostri notebook...

Magazine Ecologia e Ambiente

Possono interessarti anche questi articoli :

-

La scienza occulta del potere

SE LA MACCHINA INFORMATIVA DI INTERNET CI PERMETTE DI VENIRE A CONOSCENZA DI GRANDI MISTERI DELLA SCIENZA è altrettanto vero che il web pullula di siti detti... Leggere il seguito

Da Ilfattaccio

ATTUALITÀ, ECOLOGIA E AMBIENTE -

MULTINAZIONALI – Più sono grandi più sono pericolose

NON IMPORTA DOVE TU VIVA E’ IMPOSSIBILE SCAPPARE DALLA GLOBALIZZAZIONE. L’unica via d’uscita è informarsi per scegliere con coscienza prima di comprare. Leggere il seguito

Da Ilfattaccio

ATTUALITÀ, ECOLOGIA E AMBIENTE -

Realtà aumentata: un Marte olografico per gli scienziati della missione Curiosity

Una nuova tecnologia, chiamata OnSight, consentirà agli scienziati di lavorare virtualmente su Marte.Frutto di una collaborazione tra la NASA e Microsoft,... Leggere il seguito

Da Aliveuniverseimages

ASTRONOMIA, RICERCA, SCIENZE -

Aprire le proprie rubriche di contatti di Gmail con un programma standalone in...

In questo post vedremo come aprire tutte le rubriche contatti memorizzate negli account di posta di Google / Gmail. Queste rubriche sono in genere... Leggere il seguito

Da Giuseppe Celsi

SCIENZE, TECNOLOGIA -

WPS Office suite proprietaria per Linux

Accanto alle suite non proprietarie che abbiamo già trattato in vari articoli come LibreOffice, OpenOffice e Calligra, ci sono quelle proprietarie come WPS... Leggere il seguito

Da Marcocicconetti

MEDICINA, SCIENZE -

WEB – Ognuno di noi è una cavia

LE GRANDI AZIENDE INFORMATICHE MONITORANO LE NOSTRE RICERCHE E LE NOSTRE ABITUDINI IN RETE. Ognuno di noi, ogni giorno, è la cavia di centinaia di esperimenti. Leggere il seguito

Da Ilfattaccio

ATTUALITÀ, ECOLOGIA E AMBIENTE