Nello scorso articolo: L’inarrivabile Nextgen. Abbiamo trattato in linea teorica l’evoluzione di una console, dalla sua immissione sul mercato fino al suo pensionamento con annessa presentazione della successiva generazione.

Tuttavia è stato detto ben poco circa l’ultima scelta in casa Sony e Microsoft, che dopo anni di hardware prodotti in casa hanno tentato la rivoluzione x86, facendo storcere il naso di un po tutta l’utenza tech in generale, ancora intenta a capire quanto sia stata vantaggiosa tale migrazione. E quindi tralasciando le sbrilluccicose videate circa i vantaggi di questa nuova gen (proposte per tutto l’arco del 2013 fino al rilascio ufficiale), andiamo a vedere più nel dettaglio le differenze che caratterizzano la passata e la futura gen:

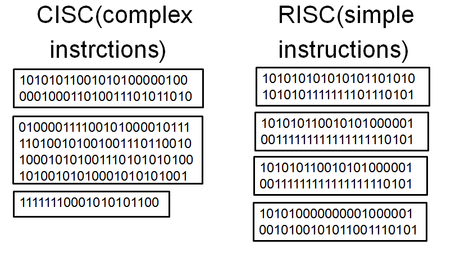

In primo luogo va detto che entrambe possiedono un architettura basata su due filosofie di elaborazione dati differenti, si parla infatti di architettura RISC (PS3/360) contro architettura CISC (PS4/One).

L’architettura RISC (acronimo di: Reduced Istruction Set Computer) è basata su un set di istruzioni avente ognuna uno specifico compito, ad esempio vi sarà un istruzione per: la lettura, la scrittura o la modifica di dati contenuti all’interno dei registri del microprocessore.

Di conseguenza per la suddetta caratteristica, questo paradigma di programmazione è il più lineare e quindi anche il più veloce per accedere ai dati caricati in memoria, tuttavia esso necessita di un maggior numero di linee di codice e di spazio di esecuzione.

Quella CISC (acronimo di: Complex Istruction Set Computer) è al contrario provvista di un set di istruzioni maggiormente specializzato, in grado di eseguire più operazioni in maniera singola.

Tale paradigma di programmazione fù introdotto con i primi chip Intel a partire dal 80486, che a differenza dei suoi predecessori RISC, permetteva di avere un minor numero di istruction set (e quindi un maggior quantitativo di spazio in memoria date le minori istanze), ma anche una maggior utilizzo di risorse di elaborazione.

Vien da sè che data la complessiva di sviluppo di un titolo (porting inclusi), il budget a disposizione fosse maggiormente indirizzato alla strutturazione del codice base (con relativa ricerca di metodologie di semplificazione), che non ad incrementarne le possibilità di rendimento su una specifica versione di devkit, e se poi si includeva anche la ricerca sull’hardware creato ad-hoc per quella console i costi aumentavano esponenzialmente, come appurato dalla precedente generazione.

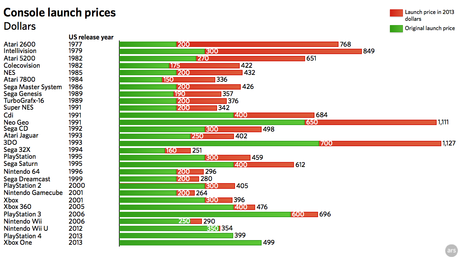

Che come rapporto qualità/prezzo non fù una delle migliori, di conseguenza bisognava cercare il giusto compromesso che non intaccasse gli introiti per un lungo periodo, lasciando intatta la durata complessiva della macchina. Ciò rese l’architettura x86 la soluzione definitiva, che combinava i costi abbordabili di soluzioni già presenti e rodate da tempo (che avrebbero quindi ridotto in larga parte i difetti di gioventù), alla semi-customizzazione hardware che appunto avrebbe conferito la tipica durata massima a questa piattaforma, nonostante io raggiungimento delle possibilità di un architettura RISC non sarebbero state mai raggiunte.

In poche parole “cheap and performance” è stata la frase chiave per tutto il ciclo di testing della nextgen, anche se strano a dirsi, la decennale esperienza sul campo ottenuta con Cell e Xenon avrebbe comunque rispecchiato tale volontà, ciò rende di fatto leciti i sopracitati dubbi, che si spera non rendano arduo l’obiettivo da raggiungere.

Cosa si cela realmente dietro le scelte della Nextgen

![Microsoft potrebbe sostituire Windows Phone Android? [RUMOR]](https://m22.paperblog.com/i/289/2897678/microsoft-potrebbe-sostituire-windows-phone-c-L-fT9C0B-175x130.jpeg)